KI, die nächste Welle

Was kommt nach ChatGPT-4?

12.10.2023 - ChatGPT ist weder neu, noch einzigartig - selbst wenn die neue Version 4 nun auch Bilder kann. Eine ganze Reihe von KI-Technologien wartet in der Pipeline. Was kommt als nächster Mega-Hype?

von Sebastian Halm

Während uns der eine oder andere Kolumnist mit bemerkenswerter Ausdauer noch daran erinnert, dass die Welt demnächst wegen ChatGPT untergeht, macht sich hier und da eine gewisse Gewöhnung an die vermeintliche KI-Dämmerung breit.

1. Zum einen begreift man, dass es so neu nun auch nicht wieder ist, was da geschieht. Dass ChatGPT zwar massiv Aufmerksamkeit generiert hat, aber ähnliche Referenztechnologien schon seit Jahren unter unserer Nase gedeihen.

2. Zum anderen hat ChatGPT inzwischen so viele peinliche Patzer, dass der unterstellten Allmacht des Open-AI-Tools zunehmend engere Grenzen aufgezeigt werden. Diese Grenzen soll die neue Version GPT-4 nun nach hinten verschieben. Der größte Unterschied zwischen GPT-3 und GPT-4 liegt in der Anzahl der Werte, die in das Training des Algorithmus einfließen, die Parameter. GPT-3 wurde mit 175 Milliarden, GPT-4 mit 100 Billionen Parametern trainiert. Außerdem kann der große Bot-Bruder laut Hersteller nun auch Bilder als Input verstehen. Damit bewegt sich ChatGPT-4 vom LLM (Large Language Model) zum LMM ("Large Multimodal Model").

3. Dann sind da noch zum Dritten die tapferen Agenturen, die sich Chatbots und KI aneignen und Wege erforschen, sie in einem sinnvollen und produktiven Maße einzusetzen; etwa als Unterstützer der menschlichen Arbeitskraft.

Wenig erörtert bis nahezu undiskutiert bleibt eine Frage, die doch eigentlich ganz oben auf all unseren Agenden stehen sollte, wenn KI wirklich das unvermeidliche Schicksal der Menschheit ist: Was kommt denn jetzt als nächstes? Nach ChatGPT-4?

Die Frage hat im Grunde zwei Antworten: Zum einen gibt es da all die Konsequenzen und Technologien, die sich unmittelbar aus ChatGPT selbst ergeben - daraus entstehende Industrien und Schwester-Technologien quasi. Darüber hinausgehend, weiter gefasst fällt die Antwort aus, was eigentlich nach Generativer KI kommt, also nach der KI-Forschungsdisziplin, der ChatGPT zugrunde liegt. Stehen als nächstes die smarten Roboter auf der Matte? Oder hören endlich die autonomen Autos auf, in Stauenden zu rasseln und bevölkern unsere Straßen?

Kleiner Spielverderber vorneweg: Die Antwort ist ein wenig banaler und der Fortschritt deutlich weniger rasant. Aber verändern wird sich trotzdem einiges, und gut beraten ist, wer jetzt schon sein Geschäftsmodell darauf abklopft, was das für seine/ihre Firma bedeutet. Denn auch bei den Nachfolgern des großen Hypes ChatGPT gilt, was auch schon für den Chatbot selbst gilt - machtlos sind wir nicht gegen diesen Wandel und selbst die Geschäftsfelder, die sich am meisten ändern werden, können sich klug anpassen und aus dem vermeintlichen Gift "KI" eine Medizin machen.

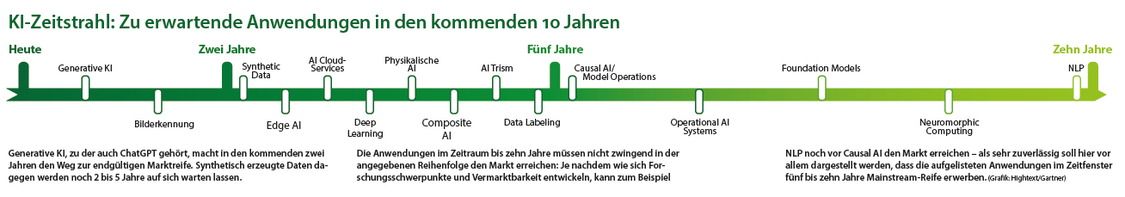

Erklärungen der verschiedenen AI-Meilensteine

- Physikalische AI: KI, die die Simulation von Naturgesetzen beinhaltet

- Decision Intelligence: Marktentscheidungs-Hilfen, etwa Berechnung des Potenzials eines Produktes

- Composite AI: Verschiedene KI-Formen werden kombiniert und kooperieren

- AI Trism: Erklärbare, nachvollziehbare KI

- Edge AI: Dezentrale KI, in die Endgeräte statt auf Servern stattfindende KI

- AI Cloud Services: AI wird ohne eigene Infrastruktur nutzbar, als Service

- Deep Learning: Sich selbst trainierende KI

- Data Labeling: Automatische Auszeichnung von Daten

- Causal AI: Weiterentwicklung von Decision Intelligence, versteht Ursachen und Wirkungen besser

- Operational System KI: Mainstream KI für EndnutzerInnen und deren Alltagsprobleme

- Neuromorphic Computing: Nach der Struktur des Gehirns modellierte AI

- Model Ops: Integrationsplattformen für KI-Lösungen

- Foundation Models: Aufgaben-unspezifisch funktionierende, Universal-AI

- Knowledge Graph: Versteht Objekte und deren Beziehungen

- Natural Language Processing/NLP: Dem Menschen ebenbürtiges Sprachverständnis

Fortschritt, die erste: Chat GPTs Folgen und Nebenwirkungen für die KI

Es gibt im Land den einen oder anderen KI-Experten, der in ChatGPT nicht nur ein großes Marketing für die Kraft der Künstlichen Intelligenz sieht, sondern ganz im Gegenteil befürchtet, dass der Dienst von OpenAI dem Forschungsfeld KI einen Bärendienst erweisen wird. So sagt etwa Professor Doktor Darius Burschka , Technische Universität München, Department of Computer Engineering, Leiter der Gruppe "Machine Vision and Perception": "Ich bin schon länger skeptisch in Bezug auf den Begriff Künstliche Intelligenz. Das was ein ChatGPT tut etwa als KI zu bezeichnen, sträubt mir die Haare: Ich glaube in der Forschung zum Thema vor allem an physikalische Modelle, an Verifikation - wissenschaftliche Aspekte, die mir bei den aktuellen Ansätzen fehlen."

Doch was genau bedeutet das? Und inwiefern greift ChatGPT hier sogar zu kurz und könnte der konstruktiven Entwicklung nachhaltiger KI-Anwendungen im Wege stehen? Es ist wie mit allen Erfindungen, die die Interaktiv-Branche erreichen: Sie werden begierig von allen Seiten darauf abgeklopft, wie man schnell und einfach damit Geld verdienen kann. Tatsächlich ist KI ein machtvolles Tool, doch will man es sinnvoll einsetzen, bedarf es eben all jener Arbeit, die ChatGPT vermeintlich gerade überflüssig macht. Man braucht nur ein Add-On oder ein entsprechendes Chatbot-Modul zu nutzen und fertig. Doch de facto ist ChatGPT, böse gesagt, so etwas wie Fast-Food-KI. Vortrainiert statt vorgekocht, aber ebenso schnell gemacht und irgendwie schmeckt es jedem, der ehrlich genug ist, es zuzugeben - doch satt macht beides nicht. Und das hat einen Grund.

- Chat GPT ist eine datenzentrierte KI. Sie stützt sich auf eine derart große Unmenge an Texten, dass man ohne grob zu übertreiben sagen kann: Sie stützt sich auf alle Texte, die existieren. Das klingt beeindruckend, bedeutet aber vor allem: Es ist eine Lösung, die auf Erkenntnisse aus der Vergangenheit zurückgreift, in denen dann Muster sucht und darauf basierend etwas auswirft. Man kann Chat GPT fragen, wie das Wetter erfahrungsgemäß am 20. Juni in München ausfällt und bekommt ein valides Ergebnis, weil ChatGPT zu dem Thema haufenweise Daten gefuttert hat. Das Tolle daran ist: Will man so eine KI wie ChatGPT auf ein neues Gebiet übertragen, mit dem sie noch nicht vertraut ist, muss man sie einfach mit Daten füttern. Hat man genug Daten zum Verhalten der KundInnen im eigenen Shop, kann man sie in den Bot kippen und der wird dazu Auskünfte erteilen.

- Auf der anderen Seite steht modellbasierte KI. Hier werden virtuelle Modelle gebaut, die man sich des Verständnisses halber mal vorstellen kann, wie etwa richtige Modelle a lá Modelleisenbahn. In diesen Modellen lassen sich dann beispielsweise physikalische Phänomene simulieren. Das prominenteste Beispiel für eine solche modellbasierte KI, die jeder kennt, wäre wohl die Wettervorhersage. Hier simuliert man in brutal komplexen Modellierungen beispielsweise Luftströme, Druckgebiete, Landschafts- und Temperatur-Verhältnisse und schaut dann aufgrund aktueller Messungen nach, wie all dies miteinander unter den gegenwärtigen Umständen miteinander agiert und was dabei herauskommt.

Fragt man eine datenzentrierte KI wie ChatGPT nach dem Wetter morgen, wird sie sagen, dass es an diesem Datum in München erfahrungsgemäß sonnig ist bei um die 23 Grad. Eine modellbasierte KI dagegen wird vielleicht zu dem Schluss kommen, dass Klimawandel und massive Anomalien wie eine explodierte Chemiefabrik in Ost-Europa dazu führen, dass ein amoklaufendes Tiefdruckgebiet auf die Stadt zukommt und wir mit heftigen Hagelschauern und Windgeschwindigkeiten bis 150 km/h zu rechnen haben.

Ein gewisser Unterschied

Der zweite Ansatz benötigt viel Arbeit, aktuellen Input und hochkomplexe mathematische Modellierungen. Teuer, dauert. Aber anschließend findet man sich nicht vom Winde verweht und vereist im Wipfel eines Baumes wieder, weil einem ChatGPT gesagt hat, man könne in kurzen Hosen in den Biergarten gehen. Doch eben jene zuverlässigen und komplexen KI-Tools, die auf Modellen basieren, werden nicht gerade durch ChatGPT gefördert. Schließlich ist der magische Bot, der uns alle überflüssig macht, so einfach zu bedienen, jeder glaubt ihn zu verstehen und mal im Ernst: Warum soll man denn viel Geld und Zeit in so eine modellbasierte KI stecken, im Web gibts das doch für einen Bruchteil des Geldes als datenbasiertes Add-On!

Vor diesem Hintergrund ergeben sich einige Trends, die uns nun im Fahrwasser des ChatGPT-Hypes erreichen werden, die mittelfristigen Trends.

Trend: Chatbots als Datenlecks

In einigen Betrieben, darunter solche Giganten wie Amazon, schieben die Unternehmensrichtlinien der Bot-Verwendung einen Riegel vor. Grund: Es ist bereits vorgekommen, dass man geschützte Programme und sensible Daten mit dem Bot kombiniert hat, der diese dann für sein Training weiterverwendet und zurückgespielt hat an seine Server. Und ehe man sich versieht, schmeißt man als Onlinekonzern einem Bot-Anbieter ebenso arglos Daten in den Hals, wie ein Nutzer oder eine Nutzerin, der oder die ChatGPT nutzt, unwillkürlich Daten über sich selbst und seine oder ihre Interessen preisgibt, wenn er oder sie das Tool nutzt.

Trend: Der Aufstieg der datenzentrierten Fast-Food-KI

Systeme, die auf vortrainierten Daten aufbauen, werden die kommenden Jahre Vorfahrt gegenüber den aufwändigeren KIs erhalten, die sich der komplizierteren Modellierungen bedienen. Konkret werden das vor allem Anwendungen sein, die aus dem Machine Learning kommen, also Algorithmen benutzen, die in einem Datentopf Muster erkennen können, die man ihnen beigebracht hat; und im weiteren werden noch die Deep-Learning-Anwendungen von mehr Aufmerksamkeit profitieren, die Daten durchforsten und selbstständig Muster finden, nicht nur solche, die man ihnen beigebracht hat. Die Versprechen des Deep Learning reichen nahe an die Leistungen einer modellbasierten KI heran, sind aber nach wie vor nur datenzentriert.

Trend: Die KI-Abmahn-Industrie

Wer sich die Mühe gemacht hat, mal das Kleingedruckte von KI-Chatbots zu lesen, entdeckt, dass das Urheberrecht der generierten Texte in der Regel bei der Herstellerfirma liegt. Wer also einen solchen Text auf seiner Homepage veröffentlicht, müsste Tantiemen an einen Hersteller wie beispielsweise OpenAI zahlen. "Hoho, das kann natürlich mir nicht passieren, denn ich schreibe den Text um!" wird da die gängige Antwort lauten, doch ein Bot, der es schafft, sämtliche existierenden Texte nach Mustern zu durchforsten, wird es auch hinbekommen, ein Wasserzeichen in generierten Texten unterzubringen, das man selbst nach x Korrekturschleifen noch nicht beseitigt hat. Das können zum Beispiel mathematische Hinweise in verwendeten Worten und deren Länge, Häufigkeit oder Verteilung sein, die so komplex sind, dass man sie weder bemerken noch entfernen kann. "Will man wissen, was nach Chat GPT kommt, muss man sich fragen, womit sich Geld verdienen lässt", sagt Professor Doktor Julius Schöning , Hochschule Osnabrück, Fakultät Ingenieurwissenschaften und Informatik. "Vor diesem Hintergrund könnte die nächste relevante KI-Technologie eine sein, die Bot-Texte erkennt, selbst redigierte und dann identifiziert, ob ein Text auf einer Homepage von ChatGPT kommt. Und dann machen entweder die Abmahnanwälte oder Firmen mit offener Hand die Runde und kassieren Abmahngebühren ab."

Trend: Menschliche Korrektur statt Künstliche Intelligenz - Justiert wird hinten raus

Was wäre Künstliche Intelligenz ohne ein wenig gutbekannten, alten Rassismus und Sexismus? Antwort: Es wäre wirkliche Künstliche Intelligenz, doch da sie weder intelligent ist (sie erkennt und reproduziert Muster) und auch nicht künstlich (sie basiert auf Daten von Menschen), wiederholt KI stumpf übelste Klischees. Es gibt stichhaltige Hinweise darauf, dass ChatGPT in den hintersten Winkeln des Dark Webs trainiert wurde und Zugriff auf Daten hatte, die die wenigsten Menschen sehen wollen, die eine demokratische Gesinnung und straffrei ausübbare, sexuelle Vorlieben besitzen. Doch Algorithmen nehmen alles zum Training mit, was sie können. Deswegen besitzen sie in der Regel eine oder alle der drei Varianten von "Bias", also virtueller Voreingenommenheit. Diese Bias gar nicht erst ins System zu lassen, würde eine kontrollierte Datenauswahl, eine genaue Überprüfung der Erhebungsprozesse und dann eine ebenso gründliche Analyse der Verarbeitung erfordern. De facto weiß man aber weder, was in den Daten steht (zu große Mengen) und wie sie vom Algorithmus verarbeitet werden (zu komplex und dynamisch in der Gewichtung der Faktoren, je nach Input).

Also was tun? Protoypisch für den industriellen Umgang mit Rassismus in KI sei hier der Fall einer Bilderkennung genannt, die immer, wenn ein Weißer ein Thermometer in der Hand hatte, darin ein Thermometer erkannte, aber stets eine Pistole, wenn es ein Schwarzer hielt - denn wenn das Internet der Lehrmeister ist, dann kommt man eben zu der Erkenntnis, dass Schwarze grundsätzlich kriminell seien. Die Lösung in diesem Fall - und eben auch in sämtlichen vergleichbaren Fällen - ist aktuell, die ausgeworfenen Erkenntnisse umzulabeln. Befindet also eine KI, dass ein schwarzer Mensch eine Knarre hält, dann entfernt man das Daten-Schild "Knarre" vom Ergebnis, händisch. Der Rassismus ist nach wie vor im System, irgendwo - keiner weiß wo. Dieses Problem wird uns als Trend begleiten und bringt einige neue Trends im Gefolge mit.

Trend: Altersfreigaben und Ethik-Richtlinien für KI

Auf Dauer sind Rassismus, Sexismus oder anti-demokratische Elemente nicht händisch korrigierbar, "neben KI brauchen wir modellbasierte Lösungen, die nicht nur erkennen, wenn etwas faktisch nicht korrekt sein kann, sondern auch erkennen, wenn etwas ethisch bedenklich ist", sagt Julius Schöning. "Doch das ist noch ein weiter Weg, bis Maschinen da ankommen, was Menschen instinktiv erkennen. Ein für Kinder ungeeigneter Witz fällt Menschen sofort auf, Agenten-Lösungen wie Googles Assistant, Alexa und Co werfen manchmal Humor aus, der nahe oder jenseits einer subjektiven Geschmacksgrenze liegt."

Okay - aber was kommt wirklich an neuen Technologien nach ChatGPT?

Dies sind einige der Phänomene, die man zugegebenermaßen nicht als neue Technologien bezeichnen kann, sondern eher als Nebenwirkungen und zu bewältigende Probleme. Doch was kommt denn Neues aus der KI-Küche, wenn wir die Texte der generativen KI verdaut haben? Zum einen wird die nächste Stufe der Bildgenerator sein. Aktuell produzieren diese Tools bereits sehr gut Gegenstände, so dass man Stilleben bei einem Zugang zu einer der Tools nicht mehr aus einer Stock-Photo-Börde ziehen muss. Es hapert noch massiv bei den Menschen, die oftmals mutierten Zombies ähneln mit Fingern wie eine Portion Fritten. Das dürfte auch der Grund sein, warum die kursierenden KI-generierten-Bilder aktuell oft Fantasy-Motive zeigen (Monster und merkwürdige Outfits gehen hier unter) oder Science-Fiction-Szenarien kreieren (Raumanzüge und Roboter maskieren die furchtbaren Finger-Darstellungen). KI-generierte Bilder lassen sich im weitesten Sinne auch als Beispiel vortrainierter generativer KI begreifen. Was aber steht denn wirklich Neues ins Haus?

Trend: Physikalische KI

Modellbasiert und anhand von beispielsweise Naturgesetzen trainiert, kann Physikalische AI realistisch darstellen, wie sich etwa ein Tropfen auf einer Oberfläche verhält. Der Unterschied zu entsprechenden Experimenten Googles mit datenbasierter KI zeigt sich an komplexen, am Rechner simulierten Proteinketten: Hier hat Google einige chemische Verbindungen erschaffen, die zwar theoretisch denkbar sind, aber in der Realität aus verschiedenen Gründen sofort zerbröseln würden, beispielsweise weil sie zu groß und schwer sind. Eine physikalische KI hätte diese Faktoren berücksichtigt.

Trend: Explainable AI/Erklärbare KI

Aktuell weiß man aufgrund der komplexen Algorithmen und obskuren Datenquellen nicht, wie eine KI ihre Entscheidungen trifft. Erklärbare KI-Modelle erlauben nicht nur dem Programmierer nachzusehen, wieso etwa Rassismus in die Ergebnisse gekommen ist. Sie taugt dann sogar für Anwendungen, die beispielsweise eine offizielle Freigabe brauchen - Beispiel autonomes Fahren, wo die Nachvollziehbarkeit der Lenkentscheidungen einer KI einen TÜV-Informatiker das System prüfen und für gut befinden lassen kann. Auch Vorfälle wie die erfolgreiche Klage einer US-Lehrergewerkschaft gegen einen Beurteilungs-Algorithmus müssten sich dann nicht mehr ereignen. Die Lehrer hatten geklagt und gewonnen, weil Personalentscheidungen aufgrund einer KI getroffen wurden, die Entscheidungen außerhalb der Nachvollziehbarkeit traf. "Viele künstliche neuronale Netze sind zu tief, haben zu viele Schichten, die nicht einmal zur zum Problemlösung beitragen", sagt Julius Schöning. "Wenn man diese Schichten entfernt, kann man das System systematisch darstellen und so nachvollziehbar machen. Das wird aber in zwei Schritten geschehen: 'Erklärbare KI' wird zunächst nur für Experten erklärbar sein, im zweiten Schritt dann auch für den Laien."

KI-SEO und KI-Cybercrimes

Die Optimierung von Inhalten für Agenten und Chatbots wird zunehmend in die Portfolios von SEO-Agenturen wandern. Dabei wird sich die SEO-Geschichte wiederholen, sprich: Konkret wird dies erstmal auf der Ebene der Manipulation der Beispielgenerierung stattfinden, sogenannten Adversarial Attacks. Hier bieten sich drei Wege an:

- Entweder man kippt massenweise Daten ins Netz, die so gekennzeichnet sind, dass sie der Chatbot für etwas hält, das sie nicht sind. Man legt beispielsweise für die Nutzerin bzw. den Nutzer nahezu unsichtbare Pixel-Muster über genug Fotos von bestimmten, nachgefragten Produkten im Netz - und dann legt man diese Muster über die Produktfotos im eigenen Shop. So befindet eine KI die Fotos dann für Abbildungen der nachgefragten Produkte, obwohl sie andere Dinge zeigen. Die Datenbasis ist quasi vergiftet worden ("Poisoning Attacks").

- Oder man manipuliert statt der Datenbasis die eigenen Daten so, dass sie falsch erkannt oder eben nicht erkannt werden. Wenn eine KI etwa Spam-Mails an bestimmten Merkmalen erkennt, kann es ausreichen, den Spam-Mails ein bestimmtes Merkmal zu verpassen, das der Spam bisher nicht hatte und er kommt durch. Anders als beim Poisoning manipuliert man hier nicht auf der Ebene des Trainings, sondern weicht dem korrekten Erkennen aus ("Evasion Attack").

- Und schließlich kann man, hat man durchschaut, wie eine KI funktioniert, die Regeln derselben täuschen. Ein Beispiel ist der Go-Spieler Kellin Pelrine, der eine vermeintlich unschlagbare KI austrickste, indem er scheinbar unsinnige Züge machte, was die Mustererkennung durcheinanderbrachte ("Model Extraction").

Sklavenarbeit in KI-Industrie

Und schließlich werden wir das Entstehen einer ganzen in Billiglohn-Länder ausgelagerten Industrie erleben, die sich mit den in Asien beheimateten Klickfarmen vergleichen lässt: Menschen zeichnen zu Niedrigstlöhnen Daten mit Labels und Hinweisen aus, so dass sie für die KI lesbar werden, denn, wie Darius Burschka sagt: "Selbst Deep Learning erkennt auf einem Bild keine Dinge - der Daten-Labler erkennt sie, der Mensch, der die Daten auszeichnet." Das ist vielleicht die größte Illusion, in der wir aktuell leben - dass KI schädliche Folgen für die Menschheit haben könnte; doch kaum einer ist sich bewusst, dass bereits ihr Ursprung allzu oft einen menschenverachtenden Kern hat, von der Bias bis zur bereits stattfindenden und noch wachsenden Sklavenarbeit in der Daten-Etikettierung.

Jenseits aller moralischen Bedenken, die man hat oder nicht hat oder schnell erfolgreich wegwischt, weil Menschen so gut in selektiver Wahrnehmung sind wie Algorithmen in Mustererkennung: Es ist auch wissenschaftlich betrachtet extrem fragwürdig, was hier geschieht. Ist es realistisch anzunehmen, ein auf einer in Afrika beheimateten Klickfarm arbeitender Moslem mit Somali als Muttersprache wüsste, wie genau Daten mit ethischen, moralischen oder auch scheinbar sachlichen Labeln auszuzeichnen sind, so dass sie in eine KI passen, die im kulturellen Rahmen Westeuropas arbeiten soll?

Datenbasierte Modelle werden in den kommenden zwei Jahren der große Hype bleiben, man wird verschiedene Lösungen nach dem Bauplan von ChatGPT in unterschiedlichen Szenarien verwenden. Doch will man wirklich nachhaltige KI-Lösungen bekommen, die beispielsweise strategisch-kluge Geschäftsentscheidungen treffen oder seriöse Vorhersagen machen können, muss man ans Reißbrett und den mühsamen Weg einer modellbasierten, maßgeschneiderten Lösung mit sauberen Daten wählen.

Vorträge zum Thema:

HighText Verlag

Mischenrieder Weg 18

82234 Weßling

Tel.: +49 (0) 89-57 83 87-0

Fax: +49 (0) 89-57 83 87-99

E-Mail: info@onetoone.de

Web: www.hightext.de